L'intelligence artificielle au service du progrès social : Bob Suh

Je crois que nous sommes des animaux sociaux et, à quelques exceptions près, nous avons tendance à nous gouverner avec des mœurs et des comportements qui aident l'ensemble du groupe. Et je pense que, encore une fois, cela revient à dire que l'IA peut aider ou nuire à cela. Elle peut exploiter l'arbitrage et l'information ou la réalité, ou elle peut guider les modèles de comportement plus vers le bien commun, si vous voulez.

Intro

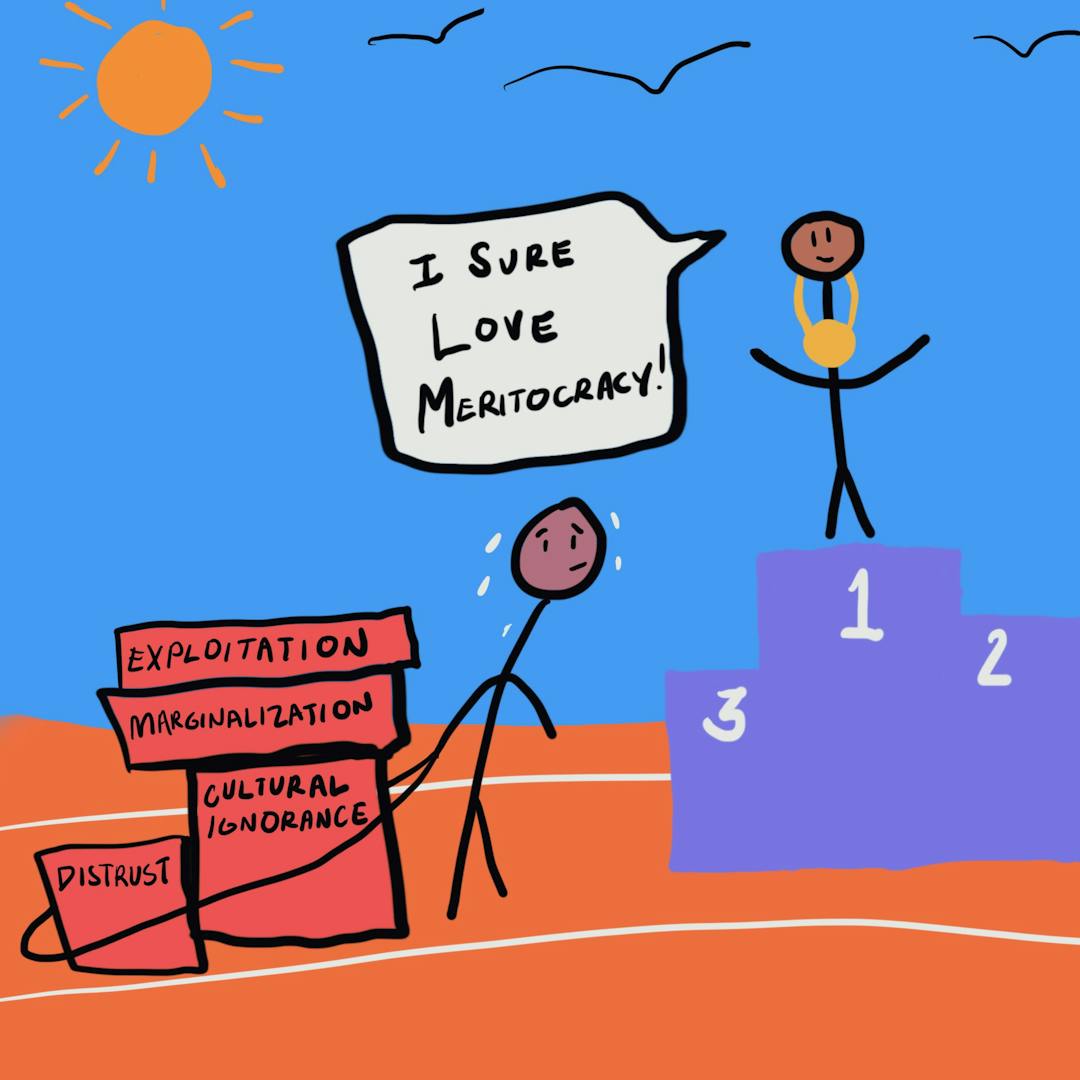

From the proliferation of social comparisons to growing political extremism, the negative effects that technology has on our societal fabric are evident. But can we create a future that looks different? One in which technology has our backs, and our best interests at heart?

On this episode of The Decision Corner, our host Brooke Struck is joined by Bob Suh, founder and CEO of OnCorps. OnCorps is an American company dedicated to elevating workplace performance outcomes through the use of artificial intelligence. By applying predictable algorithms to a variety of decisions and tasks, OnCorps reduces work, errors, and risk within the financial service industry. The organization provides cutting-edge solutions to an array of companies, with advisors from Yale, Harvard, and Oxford. Their innovative algorithms earned them the 2019 NOVA Award by NICSA and the 2019 Fintech Breakthrough Award for best banking infrastructure software.

Bob Suh has also written for the Harvard Business Review about how efficient use of AI can lead to better decision making and forecasting. Find his work here.

In this episode, Brooke and Bob discuss:

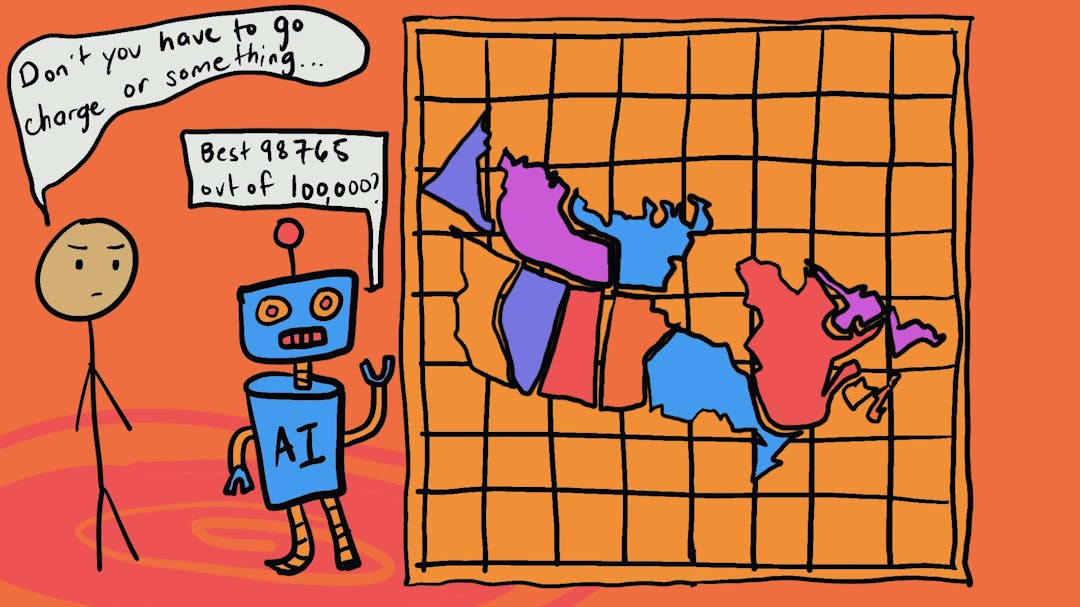

- La science comportementale fondamentale qui s'applique à l'IA

- Comment l'intelligence émotionnelle des êtres humains peut-elle être mise au service de la technologie ?

- Comment notre forte emprise sur l'analyse des données peut influencer des comportements incompatibles avec la vérité et l'authenticité, ainsi qu'une saturation de la publicité.

- Comment pouvons-nous atténuer certains de ces problèmes en utilisant la technologie pour une architecture de choix positive ?

- La monétisation des plateformes sociales actuelles et futures, et son évolution

- L'avenir de l'innovation sociale et technologique : comment la technologie évolue vers des résultats sociaux positifs